A/B‑тестирование — это метод проверки гипотез в цифровой среде. Суть его проста: сравниваются две версии одного элемента — вариант A и вариант B. Пользователи случайным образом делятся на две группы, каждая из которых видит свою версию, после чего анализируется, какой вариант дал лучший результат — например, больше кликов, регистраций или покупок.

Как это работает

Представим, что у нас есть лендинг с заголовком: «Скидка 20 процентов только сегодня». Мы предполагаем, что другой текст — например, «Успей получить 20 процентов скидки» — привлечет больше внимания.

Создаем вторую версию страницы с новым заголовком и запускаешь A/B‑тест. Половина посетителей видит старый заголовок, половина — новый. Через пару дней анализируем поведение: если новая версия уверенно показывает лучшие результаты — внедряем ее как основную.

Важно не просто менять что-то наугад, а строить гипотезу. Не «давайте сделаем кнопку красной», а «если сделать кнопку красной, пользователи начнут чаще кликать, так как она сильнее выделяется». Главное — менять только один элемент. Если вы сразу переделали и заголовок, и картинку, и текст кнопки, то невозможно будет понять, что именно сработало.

Где применяется

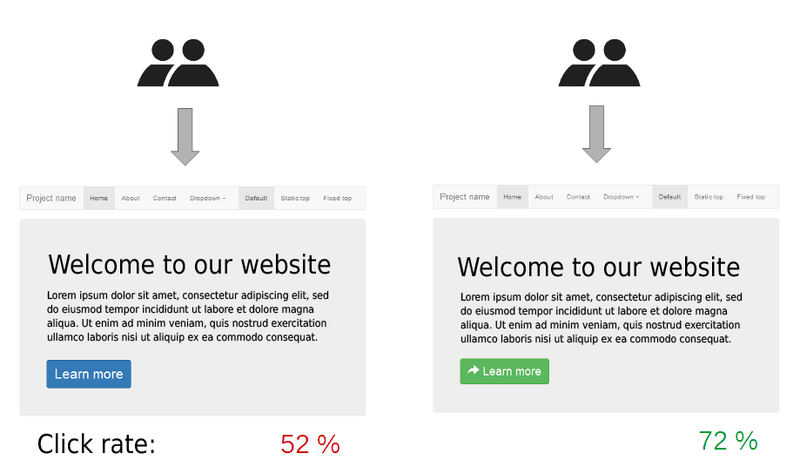

A/B‑тесты используют повсеместно — в рекламе, email‑маркетинге, продуктовой разработке, мобильных приложениях и даже в онлайн‑играх. Проверяют все: заголовки, кнопки, время отправки рассылок, длину форм, баннеры и даже фоновые цвета. Иногда изменения кажутся незначительными, но на больших объемах трафика они дают серьезную разницу в результатах.

Например, один интернет‑магазин протестировал две версии кнопки «Добавить в корзину»: обычную и чуть увеличенную. Вторая дала прирост конверсии на 7 процентов — просто потому что пользователям стало удобнее нажимать.

Как оценивать результаты

Чтобы результат теста считался достоверным, важно убедиться в статистической значимости. Иначе можно сделать вывод по случайному совпадению. Если разница между вариантами достаточно велика и вероятность ошибки мала — можно считать, что тест сработал.

На практике обычно ориентируются на p‑value меньше 0,05 — это значит, что шанс ошибки не превышает 5%. Есть онлайн‑инструменты, которые автоматически считают это — например, VWO, AB Tasty, Optimizely, а раньше еще был Google Optimize.

Тесты, запущенные на небольшом трафике, могут длиться долго и не дать четкого вывода. Поэтому важно тестировать те элементы, где есть потенциал роста, и не торопиться с выводами.

Немного истории

Метод A/B‑тестов пришел из научных экспериментов в сельском хозяйстве. В 1920‑е годы Рональд Фишер сравнивал методы посадки, чтобы понять, какие дают лучший урожай. Сегодня все то же самое делают в цифре: Netflix проверяет, какие обложки фильмов повышают просмотры, Amazon тестирует блоки рекомендаций, а крупные e‑commerce‑платформы сравнивают десятки вариантов оформления товаров.

Что важно знать

A/B‑тест — это не магия, а инструмент принятия решений на основе данных. Он не дает быстрых чудес, но помогает системно развивать продукт, понимать свою аудиторию и повышать эффективность шаг за шагом. Один тест может ничего не изменить, другой — дать рост в 15 процентов. Главное — анализировать, учиться и не останавливаться.